In der Welt der KI-gestützten Informationsverarbeitung, insbesondere bei Retrieval-Augmented Generation (RAG), ist die Wahl der richtigen Datenaufbereitungsstrategie von entscheidender Bedeutung. Eine zentrale Komponente dabei ist das sogenannte Chunking, die Aufteilung großer Dokumente in kleinere, handhabbare Einheiten. Die richtige Chunking-Strategie kann den Unterschied zwischen oberflächlichen und präzisen Antworten ausmachen, da sie direkt die Effizienz und Qualität der generierten Ergebnisse beeinflusst. Stellen Sie sich vor, Sie haben ein umfangreiches technisches Handbuch, das schnell durchsucht werden muss: Eine geeignete Chunking-Methode kann dabei unterstützen, relevante Abschnitte effizienter zu identifizieren und die präzise Beantwortung von Anfragen zu erleichtern. Dadurch werden die Chunks, also die generierten kleineren Textabschnitte, definiert, die im RAG-Prozess direkt vom Language Model verarbeitet werden, um gezielt Fragen zu beantworten.

In diesem Artikel untersuchen wir verschiedene etablierte Chunking-Strategien zur Datenaufbereitung im RAG-Prozess und zeigen anhand von Beispielen, wie jede Methode die Strukturierung der Daten für präzise und effiziente Antworten unterstützt.

Wenn Sie mehr über den Chunking- und Vektorisierungsprozess im RAG erfahren möchten, lesen Sie unseren vorherigen Blogbeitrag mit dem Titel: Effiziente Datenaufbereitung und Basiskomponenten für RAG.

Vektordatenbanken im RAG

Im RAG-Prozess spielen Vektordatenbanken eine zentrale Rolle, da sie eine semantische Suche ermöglichen, die weit über die Fähigkeiten traditioneller Suchmaschinen hinausgeht. Herkömmliche Suchmaschinen verwenden eine Vielzahl an Techniken, wie Tokenisierung und Synonym-Erkennung, konzentrieren sich jedoch auf die lexikalische Verarbeitung, um Ergebnisse zu liefern, ohne tiefere semantische Zusammenhänge zwischen Wörtern und ihrem Kontext zu erfassen. Vektordatenbanken hingegen bieten einen ganzheitlicheren Ansatz, indem sie semantische Ähnlichkeiten zwischen Anfragen und Dokumenten erkennen. Vektordatenbanken hingegen bieten einen ganzheitlicheren Ansatz, indem sie semantische Ähnlichkeiten zwischen Anfragen und Dokumenten erkennen:

- Benutzeranfragen als Sätze, nicht nur als Stichworte: Während klassische Suchmaschinen hauptsächlich auf Schlüsselwörter reagieren, verarbeitet eine Vektordatenbank vollständige Sätze oder sogar längere Texte.

- Umwandlung in Vektoren: Um eine semantische Suche zu ermöglichen, wird jede Anfrage mithilfe fortschrittlicher maschineller Lernmodelle, wie beispielsweise Transformer-Modelle, in einen numerischen Vektor umgewandelt. Diese Vektoren dienen als mathematische Repräsentation der Bedeutung von Texten.

- Suche nach ähnlichen Vektoren: In der Vektordatenbank werden Vektoren gesucht, die den Vektor der Suchanfrage am nächsten kommen und damit die am besten passenden Dokumente oder Textpassagen repräsentieren. Die semantische Ähnlichkeit wird anhand der Distanz zwischen den Vektoren gemessen.

- Sortierung nach semantischer Nähe: Die gefundenen Vektoren werden dann nach ihrer Nähe zum Abfragevektor sortiert, sodass die relevantesten Ergebnisse zuerst angezeigt werden. Kürzere Abstände bedeuten dabei eine höhere inhaltliche Übereinstimmung. Diese Art der Sortierung ermöglicht es, präzisere und kontextuell passendere Informationen zu liefern.

Die Dokumente oder Textausschnitte, die die semantische Suche in der Vektordatenbank identifiziert hat, dienen anschließend als kontextuelle Grundlage für den RAG-Prozess. Da das Large Language Model (LLM) auf präzise und relevante Texte angewiesen ist, wird dieser Kontext genutzt, um zielgerichtete und genaue Antworten zu generieren.

Chunks und Vektordatenbanken: Die perfekte Symbiose für präzise Ergebnisse

Um den Kontext für die Textgenerierung möglichst präzise zu gestalten, werden in Vektordatenbanken nicht die Vektoren ganzer Dokumente gespeichert, sondern vielmehr die Vektoren kleinerer Abschnitte, sogenannten Chunks. Diese Aufteilung ermöglicht es, spezifischere und relevantere Informationen für die Anfrage des Nutzers abzurufen. Die Wahl der optimalen Chunking-Strategie hängt von verschiedenen Faktoren ab, wie der spezifischen Aufgabe des RAG-Systems und der Beschaffenheit der zugrundeliegenden Dokumente. Es gibt keine allgemeingültige Lösung, und oft ist es notwendig, verschiedene Ansätze auszuprobieren, um die beste Chunk-Größe und -Strategie zu ermitteln.

Bei der Auswahl einer geeigneten Chunking-Strategie spielen zwei Hauptparameter eine Rolle: die Chunk-Größe und die Chunk-Überlappung. Die Größe bestimmt die maximale Länge des Textabschnitts, der in einen Vektor umgewandelt wird, aber es kann vorkommen, dass die tatsächliche Anzahl der Wörter pro Chunk geringer ist, abhängig von der Struktur des Textes und der Art der Tokenisierung. Die Überlappung definiert, wie stark die einzelnen Abschnitte sich überschneiden, um sicherzustellen, dass keine wichtigen Informationen verloren gehen. Die optimale Einstellung variiert je nach Anwendungsfall: Für umfangreichere oder komplexere Inhalte können größere Abschnitte sinnvoll sein, während für spezifischere Informationen kleinere Abschnitte und eine größere Überlappung bevorzugt werden können. Diese Feinabstimmung hilft, relevante Daten präzise zu extrahieren, ohne dabei wesentliche Zusammenhänge zu übersehen.

RAG-Chunkingstrategien

Als Nächstes werden wir fünf der wichtigsten und am häufigsten verwendeten Chunking-Strategien im RAG-Prozess genauer untersuchen.

1. Chunking mit fester Größe

Beim Chunking mit fester Größe werden Dokumente in Stücke einer vordefinierten Größe aufgeteilt, in der Regel basierend auf der Anzahl der Wörter, Tokens oder Zeichen. Tokens sind dabei die kleinsten sinnvollen Texteinheiten, wie Wörter oder Satzzeichen, die zur Analyse des Inhalts verwendet werden. Diese Methode ist einfach zu implementieren, kann jedoch manchmal zu einer unnatürlichen Aufteilung von Informationen führen, wie etwa der Teilung eines Wortes in zwei Hälften.

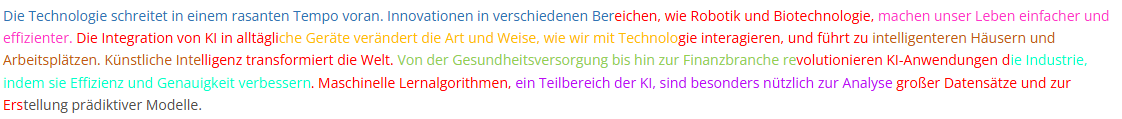

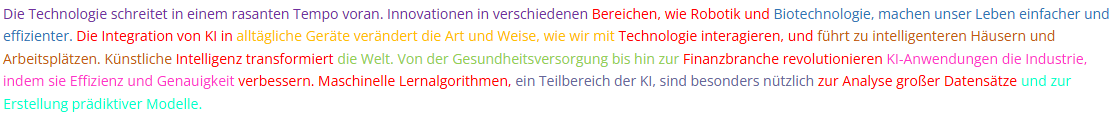

Nun betrachten wir die Ergebnisse dieser Chunking-Methode, die den Text in Abschnitte einer festgelegten Anzahl von Zeichen aufteilt. Da die Chunks unabhängig von Wort- oder Satzgrenzen erstellt werden, kann es vorkommen, dass Wörter dabei unvollständig in den Abschnitten erscheinen.

Mit einer Chunk-Größe von 120 und einer Überlappung von 30 werden die folgenden Ergebnisse geliefert:

*Anmerkung: Mit rot ist immer die Überlappung zu sehen

Ursprünglicher Text:

Chunk 1:

Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und Biotec

Chunk 2:

eichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter. Die Integration von KI in alltägli

Chunk 3:

Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und führt zu

Chunk 4:

gie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen. Künstliche Intelligenz transformiert die Welt‘,

Chunk 5:

lligenz transformiert die Welt. Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren KI-Anwendungen d

Chunk 6:

volutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern. Maschinelle Lernalgorithmen,

Chunk 7:

Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze und zur Ers

Chunk 8:

großer Datensätze und zur Erstellung prädiktiver Modelle.

Diese Methode eignet sich, wenn man eine einfache und schnelle Herangehensweise benötigt und die Struktur des Dokuments nicht entscheidend ist. Sie ist besonders nützlich bei kleineren und weniger komplexen Texten. Allerdings kann es vorkommen, dass durch die feste Aufteilung der Zusammenhang verloren geht, wenn Sätze oder Absätze zerschnitten werden, wie in unserem Fall, bei dem sogar einzelne Wörter mitten im Wort getrennt wurden.

2. Token-basiertes Chunking

Token-basiertes Chunking teilt einen Text in Abschnitte basierend auf einer festgelegten Anzahl von Token, anstatt nach Zeichen oder Sätzen. Token-basiertes Chunking ermöglicht eine präzise Kontrolle der Abschnittsgröße, was die Verarbeitung großer Datenmengen erleichtert, kann jedoch dazu führen, dass der Text an unnatürlichen Stellen getrennt wird und dadurch wichtige Informationen oder der Zusammenhang verloren gehen.

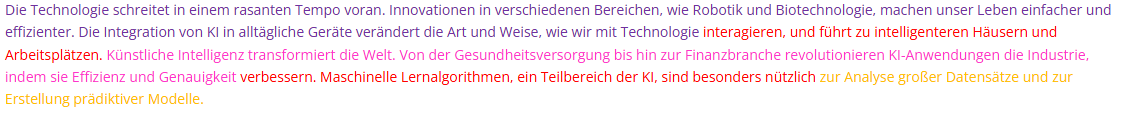

Im folgenden Beispiel verwenden wir erneut den gleichen Text wie oben und splitten ihn wieder mit einer Chunk-Größe von 120 und einer Überlappung von 30:

*Anmerkung: Mit rot ist immer die Überlappung zu sehen

Ursprünglicher Text:

Chunk 1:

Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter. Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen.

Chunk 2:

interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen. Künstliche Intelligenz transformiert die Welt. Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern. Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich

Chunk 3:

verbessern. Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze und zur Erstellung prädiktiver Modelle.

Token-basiertes Chunking bietet klare Vorteile für die Verarbeitung großer Datenmengen, da es ermöglicht, die Chunks konsistent und gleichmäßig zu gestalten, was die Verarbeitung vereinfacht und die Effizienz erhöht. Diese Methode ist besonders hilfreich, um die Abschnitte präzise zu steuern, auch wenn sie potenziell zu einer Fragmentierung des Kontexts führen kann, indem Sätze oder Absätze mittendrin unterbrochen werden, was wichtige Informationen beeinträchtigen könnte.

3. Rekursiv-basiertes Chunking

Die rekursive Textaufteilung mit Zeichen ist ein adaptiverer Ansatz, bei dem der Text durch die Verwendung mehrerer Trennzeichen in einer bestimmten Reihenfolge in Abschnitte unterteilt wird. Dabei werden die einzelnen Trennzeichen (wie Absätze, Sätze oder bestimmte Markierungen) nacheinander und entsprechend ihrer Wichtigkeit als Grenzen im Text gesetzt, um sinnvolle Abschnitte zu erstellen. Die Methode teilt den Text rekursiv auf, bis die Abschnitte eine bestimmte Größe erreichen, wobei die logische Struktur erhalten bleibt.

Im folgenden Beispiel wird derselbe Text in Abschnitte aufgeteilt, indem er in eine Liste von Zeichen zerlegt wird. Die Größe der Abschnitte wird anhand der Anzahl der Zeichen gemessen, wobei eine Abschnittsgröße von 120 und eine Überlappung von 30 verwendet wird, um das folgende Ergebnis zu erzielen:

*Anmerkung: Mit rot ist immer die Überlappung zu sehen

Ursprünglicher Text:

Generierte Chunks:

Chunk 1:

Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und

Chunk 2:

Bereichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter. Die Integration von KI in

Chunk 3:

Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und

Chunk 4:

Technologie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen. Künstliche Intelligenz transformiert

Chunk 5:

Intelligenz transformiert die Welt. Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren

Chunk 6:

Finanzbranche revolutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern. Maschinelle

Chunk 7:

verbessern. Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze

Chunk 8:

zur Analyse großer Datensätze und zur Erstellung prädiktiver Modelle.

Diese Methode eignet sich besonders für strukturierte oder hierarchische Inhalte, da sie an logischen Stellen wie Absätzen oder anderen bedeutungsvollen Einheiten trennt. Sie bietet Flexibilität bei unterschiedlichen Inhalten und ermöglicht eine präzise Anpassung der Chunk-Größe. Allerdings erfordert sie eine komplexere Einrichtung und kann bei großen Textmengen langsamer sein.

4. Dokumentenbasiertes Chunking

Beim dokumentenbasierten Chunking wird die Struktur des Dokuments gezielt genutzt, um Abschnitte entsprechend den natürlichen Grenzen wie Absätzen, Unterabschnitten oder anderen sprachlichen Merkmalen zu erstellen. Diese Methode bewahrt die inhaltliche Gliederung des ursprünglichen Autors und führt zu semantisch sinnvolleren Chunks. Dadurch werden die abgerufenen Informationen relevanter und nützlicher, besonders bei strukturierten Dokumenten mit klar definierten Abschnitten, da die Kohärenz des Textes erhalten bleibt.

Im nachfolgenden Beispiel wird derselbe Text verwendet, der in Abschnitte wie Einleitung, erster Satz, zweiter Satz usw. unterteilt wurde, und zusätzlich eine Schlussfolgerung hinzugefügt, um eine strukturierte Aufteilung zu demonstrieren.

Ursprünglicher Text:

Einleitung: Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter.

Erster Absatz: Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen.

Zweiter Absatz: Künstliche Intelligenz transformiert die Welt. Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern.

Dritter Absatz: Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze und zur Erstellung prädiktiver Modelle.

Schlussfolgerung: Die rasante Entwicklung von Technologie und KI verändert alle Lebensbereiche grundlegend, verbessert die Effizienz und eröffnet neue Möglichkeiten in verschiedenen Branchen.

Generierte Chunks:

Chunk 1:

Einleitung: Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter.

Chunk 2:

Erster Absatz: Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen.

Chunk 3:

Zweiter Absatz: Künstliche Intelligenz transformiert die Welt. Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern.

Chunk 4:

Dritter Absatz: Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze und zur Erstellung prädiktiver Modelle.

Chunk 5:

Schlussfolgerung: Die rasante Entwicklung von Technologie und KI verändert alle Lebensbereiche grundlegend, verbessert die Effizienz und eröffnet neue Möglichkeiten in verschiedenen Branchen.

Dokumentbasiertes Chunking eignet sich besonders für die Analyse großer, detaillierter Texte, die strukturiert sind oder in Abschnitte unterteilt werden können. Diese Methode stellt sicher, dass der gesamte Kontext und die wesentlichen Informationen im Dokument erhalten bleiben, ohne kritische Bereiche zu zerschneiden. Sie ist besonders nützlich für Inhalte, bei denen die logische Gliederung von Bedeutung ist.

5. Semantisches Chunking

Semantisches Chunking unterteilt den Text in Abschnitte, die auf der Bedeutung und nicht auf festen Größen basieren. Es stellt sicher, dass jeder Chunk kohärente und relevante Informationen enthält, indem es inhaltliche Wechsel in der semantischen Struktur des Textes analysiert. Dies erfolgt in der Regel durch die Messung von Unterschieden in Word Embeddings, also die Vektoren, die die Bedeutung von Sätzen mathematisch repräsentieren. Bei diesem Ansatz werden häufig fortgeschrittene Natural Language Processing Techniken (NLP) eingesetzt, um kohärente Informationssegmente zu identifizieren.

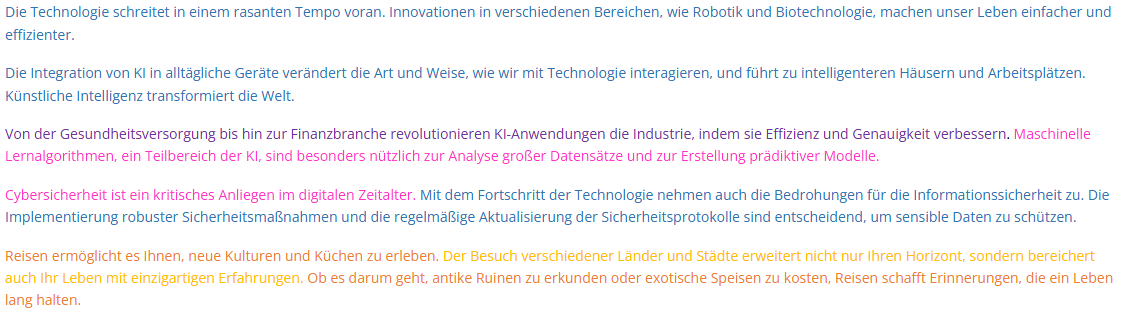

Um das Ganze hier zu veranschaulichen, haben wir einen einfachen Ansatz implementiert, bei dem der Text basierend auf der semantischen Bedeutung in Cluster aufgeteilt wird. Clustering ist eine Methode, um Daten in Gruppen zu unterteilen, die auf Ähnlichkeiten oder erkannten Mustern basieren. Im Folgenden zeigen wir die Ergebnisse, die mithilfe einer semantischen Chunking-Strategie erzielt wurden.

Ursprünglicher Text:

Chunk 1:

Von der Gesundheitsversorgung bis hin zur Finanzbranche revolutionieren KI-Anwendungen die Industrie, indem sie Effizienz und Genauigkeit verbessern.

Chunk 2:

Die Technologie schreitet in einem rasanten Tempo voran. Innovationen in verschiedenen Bereichen, wie Robotik und Biotechnologie, machen unser Leben einfacher und effizienter. Die Integration von KI in alltägliche Geräte verändert die Art und Weise, wie wir mit Technologie interagieren, und führt zu intelligenteren Häusern und Arbeitsplätzen. Künstliche Intelligenz transformiert die Welt. Mit dem Fortschritt der Technologie nehmen auch die Bedrohungen für die Informationssicherheit zu. Die Implementierung robuster Sicherheitsmaßnahmen und die regelmäßige Aktualisierung der Sicherheitsprotokolle sind entscheidend, um sensible Daten zu schützen.

Chunk 3:

Der Besuch verschiedener Länder und Städte erweitert nicht nur Ihren Horizont, sondern bereichert auch Ihr Leben mit einzigartigen Erfahrungen.

Chunk 4:

Reisen ermöglicht es Ihnen, neue Kulturen und Küchen zu erleben. Ob es darum geht, antike Ruinen zu erkunden oder exotische Speisen zu kosten, Reisen schafft Erinnerungen, die ein Leben lang halten.

Chunk 5:

Maschinelle Lernalgorithmen, ein Teilbereich der KI, sind besonders nützlich zur Analyse großer Datensätze und zur Erstellung prädiktiver Modelle. Cybersicherheit ist ein kritisches Anliegen im digitalen Zeitalter.

Diese Methode eignet sich besonders, wenn es wichtig ist, den höchsten Grad an Kontext zu bewahren, beispielsweise bei komplexen oder technischen Dokumenten. Sie erstellt kontextuell sinnvolle Abschnitte und erfasst semantische Zusammenhänge zwischen den Sätzen. Allerdings erfordert diese Methode fortgeschrittene NLP-Modelle, die rechenintensiv sind, und ist in der Implementierung komplexer.

Fazit

Chunking ist ein wesentlicher Bestandteil des (RAG)-Prozesses, da es hilft, Informationen in handhabbare Abschnitte zu zerlegen und so die Relevanz und Genauigkeit zu steigern. Bei der semantischen Suche im RAG-Prozess ermöglicht Chunking den gezielten Abruf relevanter Textabschnitte anstelle ganzer Dokumente. Dies führt zu präziseren Suchergebnissen, die besser auf den Kontext der Anfrage passen. Durch den Einsatz geeigneter Chunking-Strategien wie Fixed-Size, Semantic, Token-basiert und anderen wird sichergestellt, dass der Kontext erhalten bleibt und die Effizienz des Systems optimiert wird. Jede Methode hat ihre eigenen Vorteile und eignet sich für unterschiedliche Aufgaben und Dokumentstrukturen.

Ausblick

Wir haben hier fünf wichtige Strategien analysiert und mit Beispielen veranschaulicht, doch es gibt noch weitere Ansätze für Chunking. Eine umfassendere Darstellung hätte jedoch den Rahmen dieses Beitrags gesprengt. Die Wahl der richtigen Strategie ist entscheidend, um das volle Potenzial eines RAG-Systems auszuschöpfen und die Genauigkeit, Effizienz und kontextuelle Relevanz von KI-gestützten Informationsabruf- und Generierungssystemen zu maximieren.